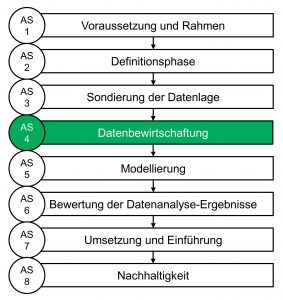

Abbildung 1: Arbeitsschritte zur Durchführung von Big Data-Projekten nach VDI 3714

Chancen und Herausforderungen von Big Data-Projekten

In der Industrie fallen massenhaft Daten an, welche wegen ihrer oft ungleichmäßigen Struktur, Größe oder Komplexität nicht schnittstellen- und formatübergreifend nutzbar sind. Solche Massendaten (engl. Big Data) können jedoch die Grundlage für eine datenbasierte Entwicklung von Modellen zur Steigerung der Wertschöpfung von technischen oder ökonomischen Prozessen bilden [1]. Für die Entwicklung von Big Data-Projekten ist eine standardisierte Vorgehensweise unerlässlich, um eine technische und wirtschaftliche Umsetzung sicherzustellen. Exemplarisch wird eine Möglichkeit aufgezeigt, wie der Abkühlverlauf von Kunststofffilamenten während der Herstellung im Extrusionsprozess mittels Thermografie erfasst und dabei entstehende Daten verarbeitet werden können. Daraus abgeleitete Modelle stellen eine durchgängige Qualitätskontrolle bereits während der Produktion sicher.

Systematische Durchführung von Big Data-Projekten

Der Verein Deutscher Ingenieure entwickelt mit der Richtlinienreihe VDI 3714 [2] einen umfassenden Leitfaden zur Durchführung von Big Data-Projekten, wonach sich die Entwicklungsarbeit in acht Arbeitsschritte (AS) strukturieren lässt (vgl. Abbildung 1). Zunächst wird überprüft, ob alle Voraussetzungen (AS 1), wie das Vorhandensein hochqualitativer und heterogener Daten, zu Projektbeginn erfüllt sind. In der Definitionsphase (AS 2) werden Projektziele hinsichtlich wirtschaftlicher und technischer Aspekte festgelegt sowie objektive Kriterien zur Bewertung des Projekterfolgs erarbeitet. Bevor gewonnene Daten wertschöpfend verwendet werden können, sollte die Datenlage sondiert werden (AS 3). Die Sondierung umfasst die ausführliche Analyse der Datenquelle, deren eindeutige Klassifizierung sowie eine Strukturierung der Daten nach ihrer Zugehörigkeit in der Wertschöpfungskette oder nach ihrer Qualität.

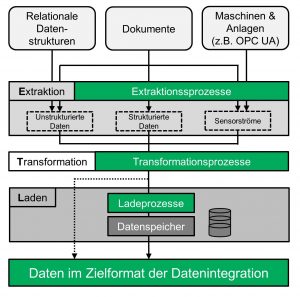

Abbildung 2: ETL-Prozess nach VDI 3714

Strukturierung von Daten – ETL-Prozesse erhöhen die Datenqualität

Mit dem Ziel, Daten für eine mathematische Modellbildung nutzbar zu machen, erfolgt in der Datenbewirtschaftung (AS 4) eine Datenanpassung auf das Modellierungsziel in sogenannten ETL-Prozessen (vgl. Abbildung 2). Daten unterschiedlicher Quellen werden extrahiert (Extract), in das zur Modellbildung benötigte Format transformiert (Transform) und in einem Datenspeicher oder einer Datenbank abgelegt (Load) [2]. Zur Extraktion der Daten muss betrachtet werden, ob die Daten online durch einen Konnektor (z.B. OPC UA-Gate einer Extrusionsanlage) oder offline als Datei (z.B. generierte CSV-Datei einer Wärmebildkamera) bereitgestellt werden. Ziel der sich anschließenden Datentransformation ist u.a. die Beseitigung von Messfehlern (semantische Transformation) sowie die Vereinheitlichung von Datentypen, Genauigkeit und Formaten, wie dem Zeitformat (syntaktische Transformation) in Hinblick auf das Modellierungsziel. Auch das Filtern von nichtbenötigten Datensätzen ist notwendig, um die Belastung der Infrastruktur zu reduzieren. Im Ladeprozess werden die modifizierten Daten in einer für das Modellierungsziel geeigneten Struktur zusammengefasst und gespeichert.

ETL-Prozess zur Modellierung des Abkühlverlaufs von Kunststoffextrudaten

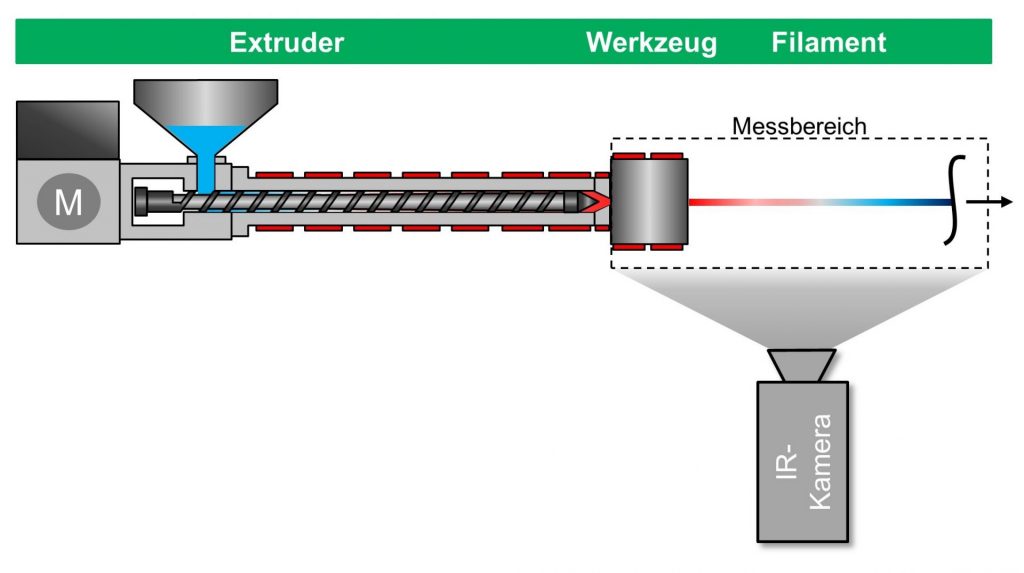

Im Folgenden soll die Durchführung eines ETL-Prozesses exemplarisch anhand des örtlichen Abkühlverlaufs von extrudierten Kunststofffilamenten erläutert werden. Der dazu verwendete Versuchsstand ist in Abbildung 3 dargestellt. Für die Ausbildung der mechanischen Eigenschaften, insbesondere des E-Moduls, ist die Abkühlgeschwindigkeit von teilkristallinen Thermoplasten von besonderer Bedeutung. Je schneller die Temperatur ausgehend von der Schmelzetemperatur (TS) unterhalb der Kristallitschmelztemperatur absinkt, desto feiner ist die Morphologie im Kunststoffgefüge. Kunststoffe mit einem geringeren Kristallisationsgrad weisen daher oft eine geringere Steifigkeit auf als hochkristalline Thermoplaste [3].

Abbildung 3: Versuchsstand zur Erfassung der Wärmeverteilung in der Filamentextrusion

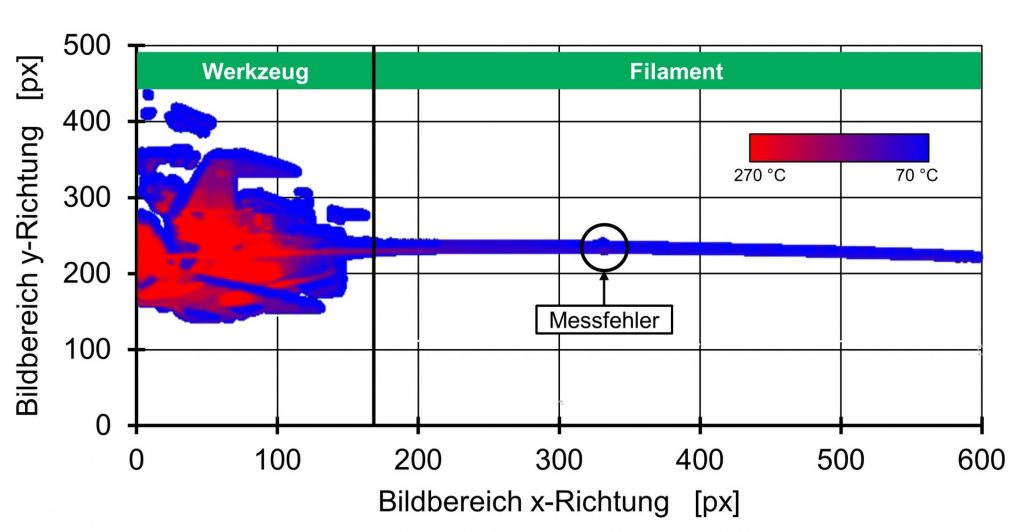

Zur berührungslosen Erfassung der Temperaturverteilung des Extrudates während des Abkühlprozesses eignet sich besonders die Thermografie in definierten Zeitintervallen (∆t = 1 s). Die Temperaturdaten werden zunächst zu einem Zeitpunkt als Matrix in einer CSV-Datei lokal gespeichert und anschließend einer Datenbank zur Verfügung gestellt (Extract). Abbildung 4 zeigt exemplarisch die Visualisierung eines CSV-Datensatzes mit 640 x 480 Datenpunkten bei der Kunststofffilamentextrusion mit der Open-Source Visualisierungssoftware Grafana, Grafana Labs, New York, USA.

Abbildung 4: Visualisierung der Wärmeverteilung in der Filamentextrusion

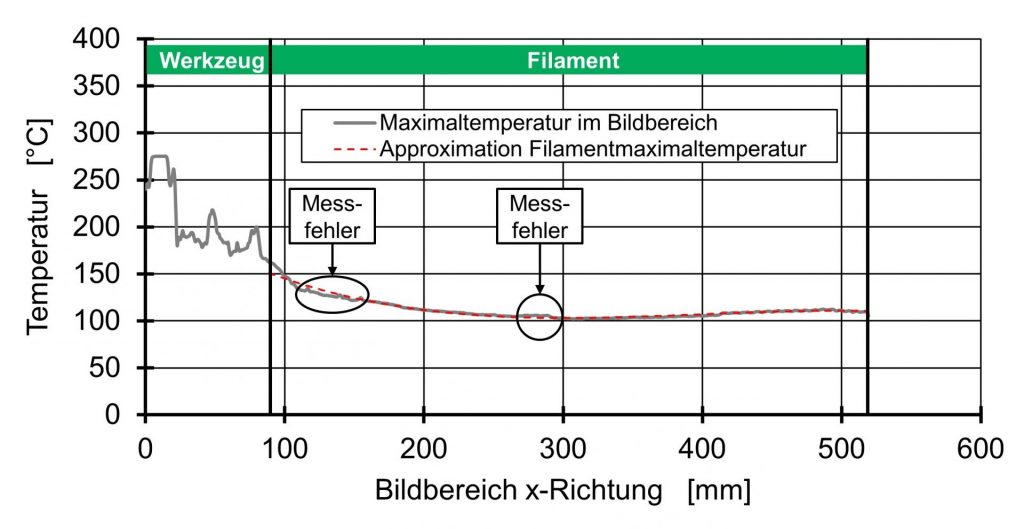

Nach der Sichtung und Visualisierung des Datensatzes beginnt die Datentransformation (Transform) mit der Tranformation der Koordinaten von Pixel-Einheiten [px] in metrische Koordinaten [mm] durch Berechnung eines Skalierungsfaktors. Die Herausforderung besteht nun in der Ermittlung der Temperaturen des gekrümmten Extrudates in Abhängigkeit der Extrusionslänge. Dazu wird in jeder Bildspalte der maximale Temperaturwert ermittelt, unter der zulässigen Annahme, dass die Hintergrundtemperaturen niedriger sind, als die des Extrudates bzw. Werkzeugs. Abbildung 5 zeigt den Maximaltemperaturverlauf im Bildbereich in metrischen Koordinaten.

Abbildung 5: Maximaltemperaturverlauf von Extrudat und Werkzeug in der Filamentextrusion

Da ausschließlich der Temperaturverlauf des Filaments für die Prozesskontrolle relevant ist, muss der unstetige Temperaturverlauf des Werkzeugs (ausgelöst durch Reflexionen auf der metallischen Oberfläche des Werkzeugs) vernachlässigt werden. Bereits durch diese simplen Transformationen kann der Datensatz von 307.200 Datenpunkten auf 530 reduziert werden. Um eine Modellbildung auf Basis valider Daten durchführen zu können, ist die Entfernung von Messfehlern (z.B. Unstetigkeiten) unerlässlich [4]. Eine Möglichkeit der Approximation des Abkühlverlaufs besteht in der Ermittlung eines Polynoms dritten Grades mit einer mittleren Abweichung von 1,8 °C (vgl. Abbildung 4), wodurch der Datensatz auf lediglich vier Koeffizienten reduziert werden kann. Die Koeffizienten werden anschließend einer Datenbank als Grundlage für die anschließende Modellbildung zur Verfügung gestellt (Load).

Datengetriebene Modellbildung und ihre Implementierung zur Steigerung der Produktivität

Die strukturierten Daten können nun für die Bildung eines Modells (AS 5) genutzt werden, welches das oftmals komplexe Systemverhalten vollständig abbilden soll. Ziel ist die Anpassung des Modells auf die gegebenen Daten mit einer anschließenden Anwendung auf bisher unbekannte Daten zur Vorhersage des Systemverhaltens. Im vorliegenden Beispiel kann der ermittelte Abkühlverlauf z.B. als Datensatz zur Vorhersage der Filamentsteifigkeit genutzt werden. Sofern a-priori ein großes Systemwissen zur Verfügung steht, kann das System mittels mathematischer Funktionen beschrieben werden (White-Box). Anderenfalls erfolgt die Modellierung alleine auf Basis der erhobenen Daten (Black-Box), beispielsweise durch Deep-Learning-Ansätze. Auch Kombinationen beider Modellierungsarten (Grey-Box-Modell) sind möglich. Nach der Validierung des Modells erfolgt die Bewertung der Datenanalyse-Ergebnisse hinsichtlich des Projektziels und der Anwendbarkeit (AS 6). Verläuft die Beurteilung positiv und neue quantitative Zusammenhänge wurden ermittelt, erfolgt im Schritt Umsetzung und Einführung

(AS 7) die Implementierung des Modells in das System. Das Spektrum reicht dabei von der Entwicklung von „Softsensoren“ oder „Prädiktoren“ zur Berechnung oder Vorhersage nicht messbarer Prozess- oder Qualitätsgrößen wie des E-Modul bis hin zu „Echtzeitoptimierern“, welche auf die Sollwerte eines Systems einwirken und den Prozess auf die Zielgröße hin regeln können. Für die Inbetriebnahme solcher Entwicklungen ist ein durchdachtes Change-Management zur Maximierung der Mitarbeiterakzeptanz unerlässlich. Aber auch wirtschaftliche und technologische Bewertung sind für einen nachhaltigen Projekterfolg (AS 8) notwendig. Im beschriebenen Anwendungsfall der Extrusion können so material- und prozessbedingte Qualitätsschwankungen erfasst und gezielt beseitigt werden.

Referenzen

[1] Obermaier, R. (Hrsg.): Handbuch Industrie 4.0 und digitale Transformation, Berlin: Springer Gabler, 2019

[2] Implementierung und Betrieb von Big-Data-Anwendung in der produzierenden Industrie – Durchführung von Big-Data-Projekten, VDI 3714 Blatt 1 – 7 (Entwurf), 2019

[3] Menges, G. et al.: Werkstoffkunde der Kunststoffe, München: Hanser, 6. Auflage, 2011

[4] Möhrke, M.; Runge, B.: Arbeiten mit Messdaten, Berlin: Springer Spektrum, 2020

Dank

Die Errichtung des Plastics Innovation Center 4.0 wird gefördert durch Mittel des Landes NRW und aus dem Europäischen Fond für Regionale Entwicklung (EFRE).

Autoren

Univ.-Prof. Dr.-Ing. Christian Hopmann ist seit 2011 Inhaber des Lehrstuhls für Kunststoffverarbeitung und Leiter des Instituts für Kunststoffverarbeitung (IKV) in Industrie und Handwerk an der RWTH Aachen.

Daniel Grüber, M.Sc. beschäftigt sich mit der Digitalisierung und datengetriebenen Modellierung von Extrusionsprozessen am IKV.

Mail: daniel.grueber@ikv.rwth-aachen.de

Tel.: 0241 80-27277

Dr.-Ing. Martin Facklam ist seit 2019 Leiter der Abteilung Extrusion und Kautschuktechnologie am IKV.